[텍스트 분석] 2-1. 텍스트 전처리 - 클렌징, 토큰화

2022.02.19 - [머신러닝 | 딥러닝/텍스트 분석] - [텍스트 분석] 1. 텍스트 분석의 이해

[텍스트 분석] 1. 텍스트 분석의 이해

프로젝트를 하면서 텍스트 분석을 접해볼 기회가 있었는데 완전한 이해를 하고 사용한 것은 아니라 오류도 많이 접해보았고 그래서 더욱 차근차근 텍스트 분석에 대해 공부해보려고 합니다! 텍

xod22.tistory.com

저번 포스팅에서 텍스트 분석의 이해에 대해 간단히 적어보았는데요!

오늘은 텍스트 분석의 프로세스 중 첫번째인 텍스트 전처리 및 정규화에 대해 공부해보려고 합니다!

문서에서 단어 기반으로 하여 피처를 뽑은 후에 피처에 벡터 값을 부여하는 작업이 필요하다.

하지만 피처에 벡터값을 부여하는 작업을 하기전! 본 데이터에 대한 전처리 작업이 필수적이다..!

텍스트 분석의 전처리 작업을 정리해보자면 다음과 같다.

1. Cleansing(클렌징)

2. Tokenization(토큰화)

3. 필터링 / stopwords(불용어) 제거 / 철자 수정

4. Stemming & Lemmatization

1. Cleansing(클렌징)

: 텍스트 분석에서 오히려 방해가 되는 불필요한 문자 등을 제거하는 작업을 말한다!

예를들어 인터넷에서 크롤링한 데이터가 있다고 했을 때, html 기호 등을 사전에 삭제하는 작업이 이에 속함..!

2. Tokenization(토큰화)

: 날것의 텍스트를 문장별, 단어별로 나누기..!

토큰화의 유형은 크게 두가지가 있다.

1) 문장 토큰화 : 문서에서 문장을 분리

2) 단어 토큰화 : 문장에서 단어를 토큰으로 분리

즉 문서->문장, 문장->단어

~패키지 임포트~

from nltk import sent_tokenize

import nltk

nltk.download('punkt')

~문장 토큰화~

: 문장 토큰화는 주로 문장의 마지막을 뜻하는 기호를 기준으로 작업이 진행된다..!

문장의 마지막을 상징하는 기호로는 대표적으로 마침표(.)와 개행문자(\n) 등이 있다.

또한 정규화 표현식에 따른 문장 토큰화도 가능하다.

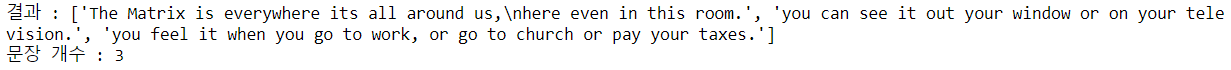

text_sample = '''The Matrix is everywhere its all around us,

here even in this room. you can see it out your window or on your television.

you feel it when you go to work, or go to church or pay your taxes.'''

# sent_tokenize(text="입력할 텍스트")

sentences = sent_tokenize(text=text_sample)

print("결과 :", sentences)

# text가 몇개의 문장으로 되어있는지 개수를 세줌

print("문장 개수 :", len(sentences))

print로 텍스트를 확인해보면, 문장별로 분리가 되어 리스트에 담겨있는 것을 알 수 있다!

~단어 토큰화~

: 단어 토큰화는 문장을 단어로 토큰화 함을 의미한다.

기본적으로는 공백, 콤마(,), 마침표(.), 개행문자 등을 기준으로 토큰화 시킨다.

from nltk import word_tokenize

sentence = "The Matrix is everywhere its all around us, here even in this room"

words = word_tokenize(sentence)

print(type(words))

print("결과 :", words)

공백을 기준으로 각 단어들이 리스트에 담겨 나타나고 있는 것을 확인할 수 있다.

~문장 토큰화와 단어 토큰화의 결합~

from nltk import word_tokenize, sent_tokenize

#함수 생성

def tokenize_text(text):

#문장별로 분리

sentences = sent_tokenize(text)

#분리된 문장별 단어 토큰화

word_tokens = [word_tokenize(sentence) for sentence in sentences]

return word_tokens

#함수에 text_sample을 넣어줌

word_tokens = tokenize_text(text_sample)

#반환값 word_tokens 출력

print(type(word_tokens), len(word_tokens))

print(word_tokens)

3개의 문장들이 각각 단어 토큰화되어 하나의 리스트에 담겨있음을 확인할 수 있다!

-> 세개의 문장이므로 세개의 리스트..!