[K-Data x 러닝스푼즈] 4-2. 임베딩과 Word2Vec

임베딩

1) Sparse Representation

: one-hot encoding

ex) 면도기 = [0, 0, 0, 0, ..,1, 0, 0, ..., 0], 차원의 개수는 아이템 전체 개수와 같다..!

벡터의 차원은 한없이 커지고 공간이 낭비된다는 특징

2) Dense Representation

: 아이템 전체 개수보다 훨씬 작은 차원으로 표현됨..!

아이템의 의미를 여러개의 차원에 분산하여 표현한다

ex) 면도기 = [0.2, 1.4, -0.4, 1.2, 0.3]

워드 임베딩

- 단어를 정해진 사이즈의 dense vector로 나타내는것이다.!!

one-hot encoding->dense representation

[0,0,1,...,0]-> 3차원[0.2, 0.4, 0.4]

- 임베딩 시키면 단어간의 의미적인 유사도를 구할 수 있음

비슷한 의미의 단어끼리는 해당 vector가 비슷한 위치에 분포한다..!

ex) 예쁘다, 귀엽다, 애교 등의 단어는 비슷한 벡터값을 가질 것으로 예상

Word2Vec

<특징>

: 대량의 문서 데이터셋을 vector 공간에 투영함

압축된 형태의 많은 의미를 갖는 dense vector로 표현

효율적이고 빠른 학습이 가능하다.

<학습방법>

- CBOW

- Skip-gram

그럼 Word2Vec을 학습하는 두가지 방법을 소개해보겠습니다!

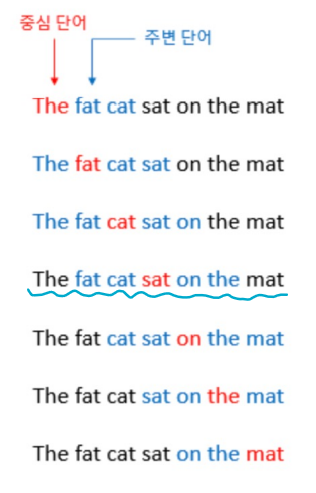

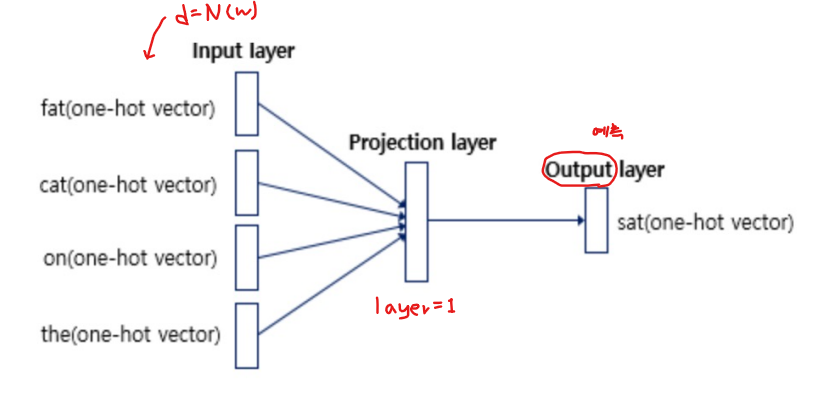

① CBOW (씨바오)

: 주변에 있는 단어를 가지고 센터에 있는 단어를 예측하는 방법

단어를 예측하기 위해 앞뒤로 몇 개(n)의 단어를 사용할 것인지 정해야 한다..!

예시)

예측 단어 : "sat"

n=2

예측 단어를 예측하기 위해 사용할 단어 : "fat", "cat", "on", "the"

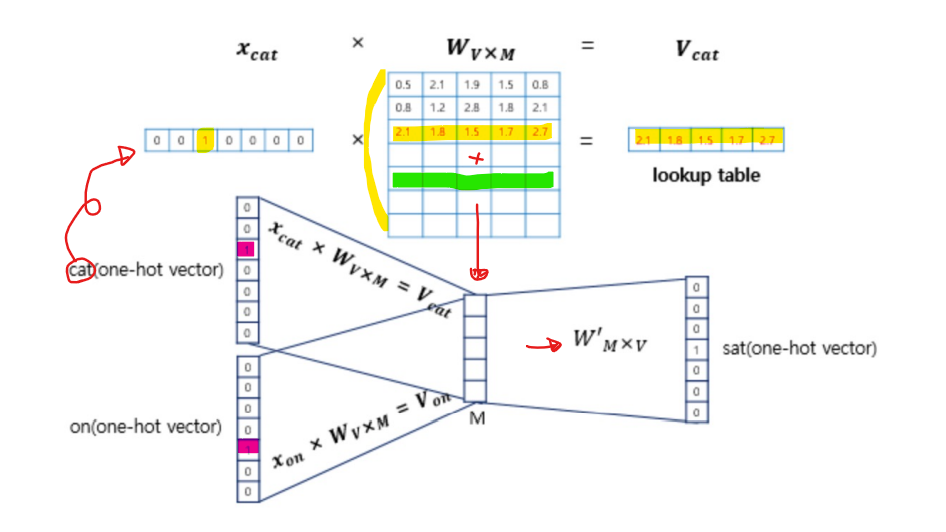

* 계산 방법

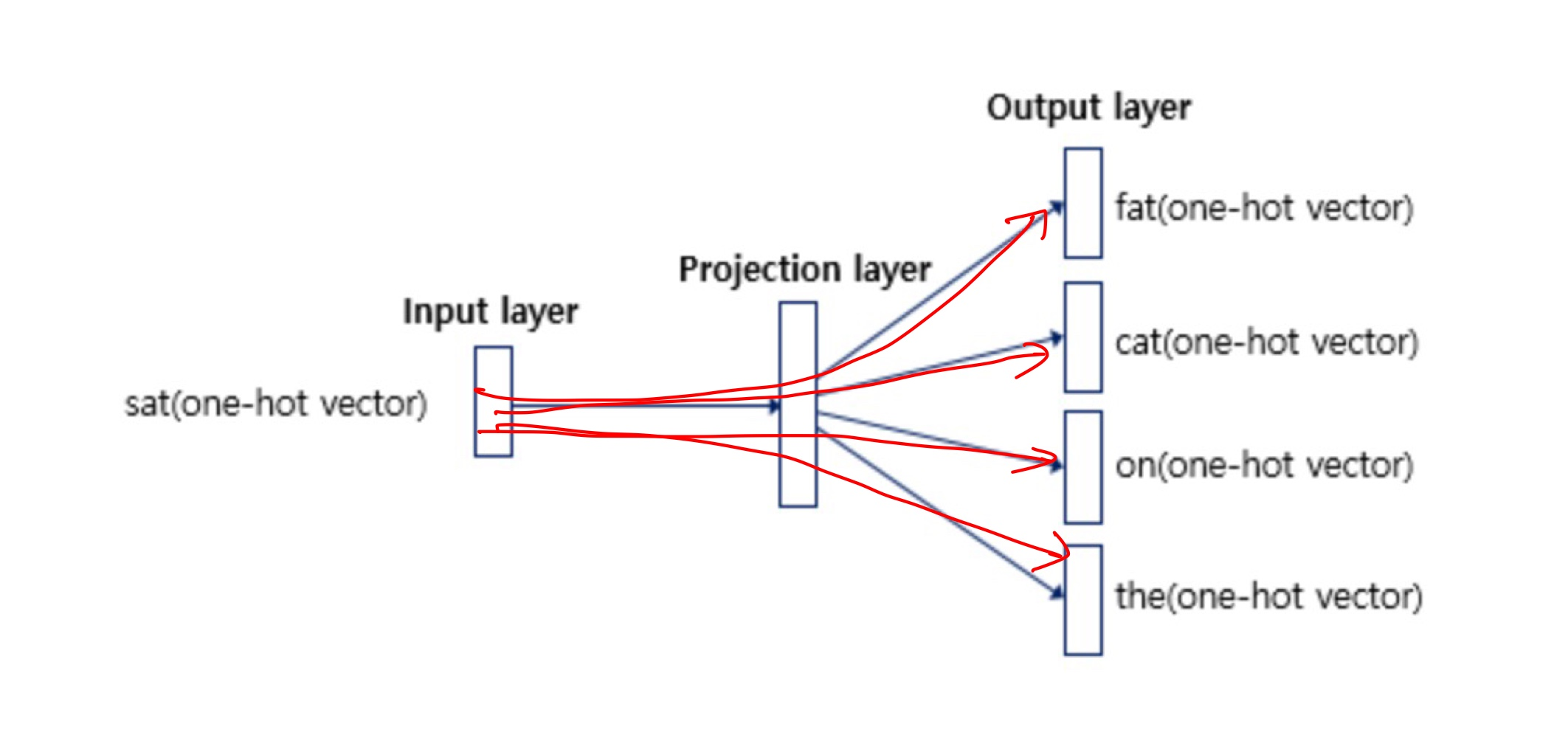

② Skip-gram Negative Sampling (SGNS)

* Skip-gram

: CBOW의 입력층과 출력층을 반대로 구성한 모델이다!

일반적으로 CBOW보다 성능이 좋다고 알려져있음!

* Skip-gram Negative Sampling (SGNS)

: multi classification -> binary classification

<Skip-gram>

<SGNS>

=> cat이라는 단어를 넣었을 때 엄청나게 많은 단어중에 sat이라는 단어를 예측해야하는 Skip-gram과 달리

SGNS는 (cat,sat)이 인접해있을 때 1, 그렇지않고 (cat,dog)같이 관련 없는 단어를 넣었을 때는 0을 뱉는

binary 문제가 됨!

* 계산방법

1) 중심단어와 주변단어가 각각 서로다른 임베딩 파라미터를 가진다.

2) 입력단어와 주변단어와의 내적을 통해 시그모이드 값으로 레이블을 표현!

=> 어떤 word에 대해서 정해진 embedding이 나온다는 것을 알 수 있듬

이번 포스팅에서는 단어를 벡터로 임베딩 시키는 법에 대해 알아보았습니다!

다음 글에서는 추천에 해당하는 아이템을 벡터로 바꿔서 추천에 활용하는 방법에 대해 적어보겠습니다~_~

그럼 오늘도 끝!